Deepseek R1本地部署

Deepseek R1本地部署

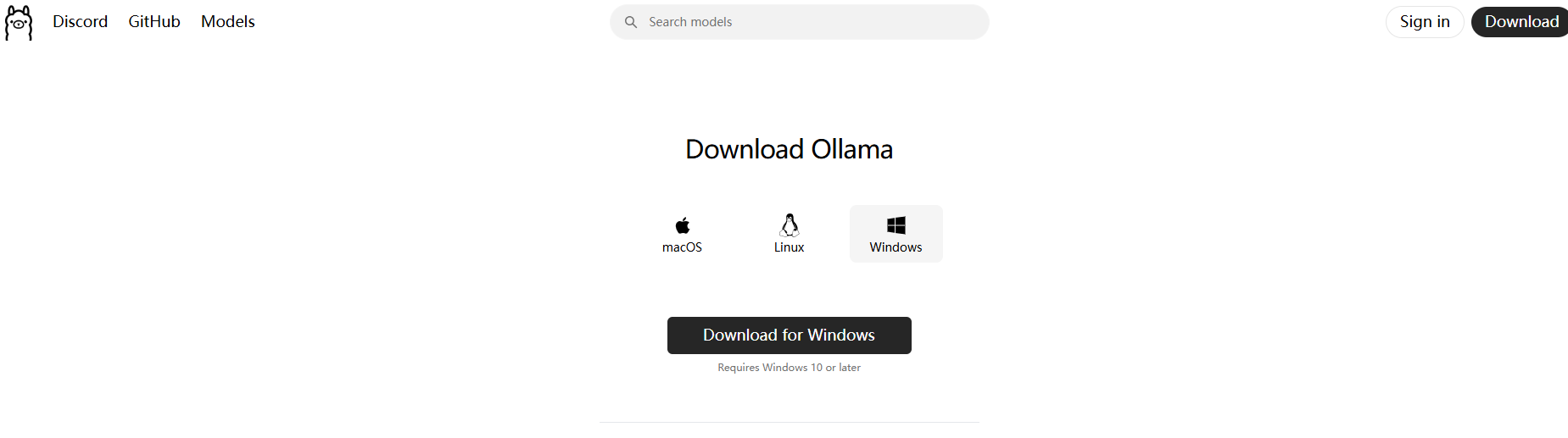

1.Ollama 下载安装

Ollama 是一个轻量级的本地AI模型运行框架,可在本地运行各种开源大语言模型(如Llama、Mistral等)

Ollama官网:https://ollama.com/

1.1 Windows平台安装Ollama

1.1.1安装客户端

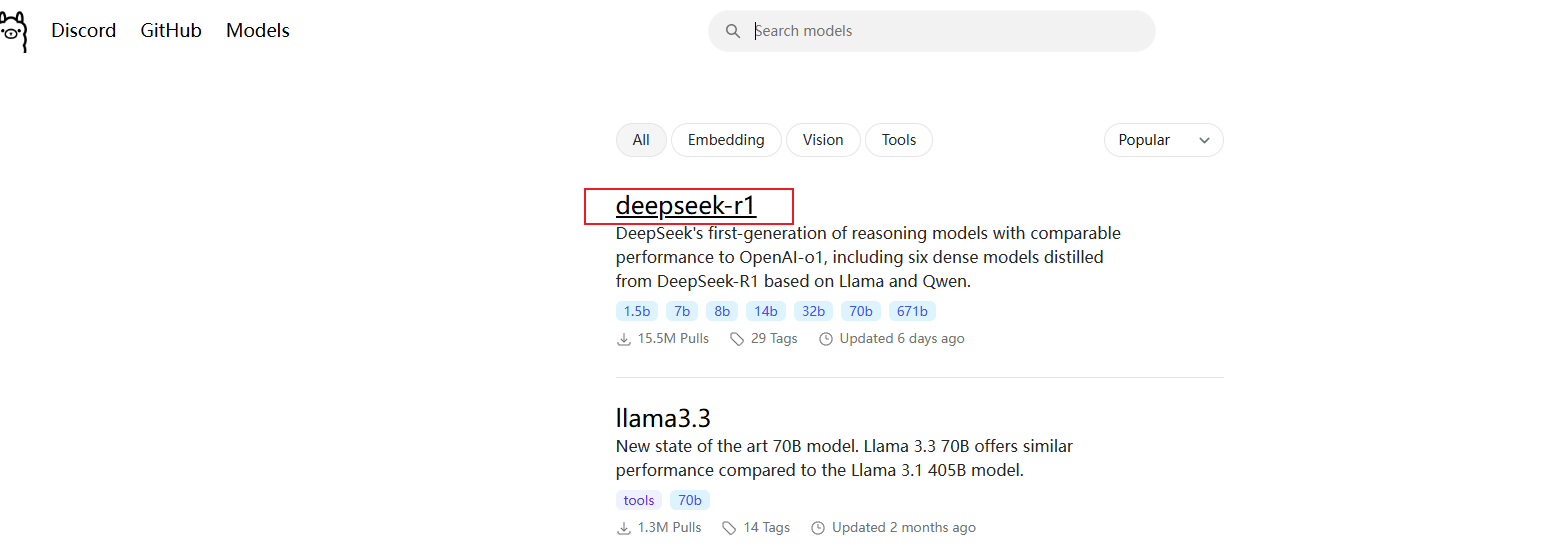

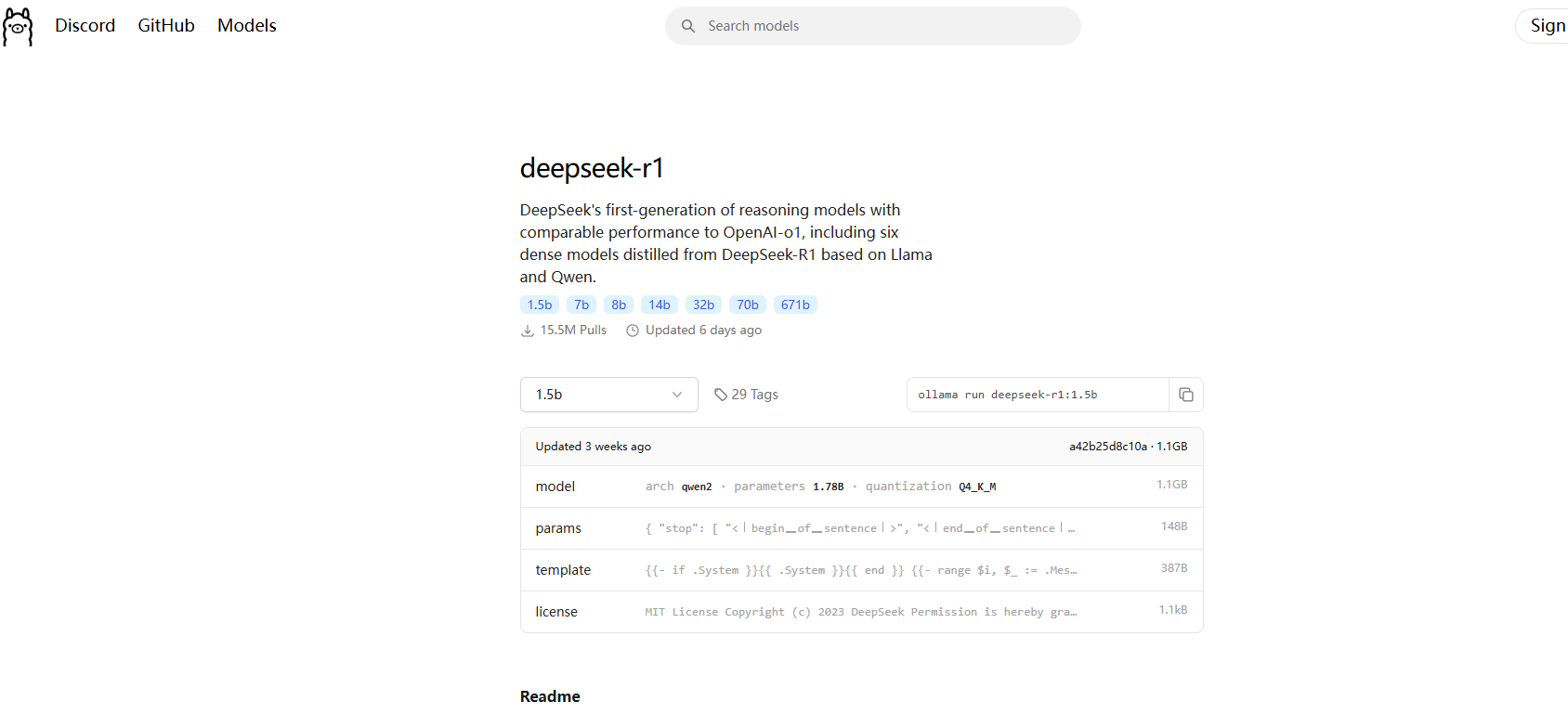

1.1.2安装DeepSeek-r1模型

还是在刚才的Ollama网站,选择Model模块,选择deepseek-r1这个模型

Deepseek本地部署硬件要求

1. DeepSeek-R1-1.5B

• CPU: 最低 4 核(推荐 Intel/AMD 多核处理器)

• 内存: 8GB+

• 硬盘: 3GB+ 存储空间(模型文件约 1.5-2GB)

• 显卡: 非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650)

• 场景:

• 低资源设备部署(如树莓派、旧款笔记本)

• 实时文本生成(聊天机器人、简单问答)

• 嵌入式系统或物联网设备

________________________________________

2. DeepSeek-R1-7B

• CPU: 8 核以上(推荐现代多核 CPU)

• 内存: 16GB+

• 硬盘: 8GB+(模型文件约 4-5GB)

• 显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

• 场景:

• 本地开发测试(中小型企业)

• 中等复杂度 NLP 任务(文本摘要、翻译)

• 轻量级多轮对话系统

________________________________________

3. DeepSeek-R1-8B

• 硬件需求: 与 7B 相近,略高 10-20%

• 场景:

• 需更高精度的轻量级任务(如代码生成、逻辑推理)

________________________________________

4. DeepSeek-R1-14B

• CPU: 12 核以上

• 内存: 32GB+

• 硬盘: 15GB+

• 显卡: 16GB+ 显存(如 RTX 4090 或 A5000)

• 场景:

• 企业级复杂任务(合同分析、报告生成)

• 长文本理解与生成(书籍/论文辅助写作)

________________________________________

5. DeepSeek-R1-32B

• CPU: 16 核以上(如 AMD Ryzen 9 或 Intel i9)

• 内存: 64GB+

• 硬盘: 30GB+

• 显卡: 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

• 场景:

• 高精度专业领域任务(医疗/法律咨询)

• 多模态任务预处理(需结合其他框架)

________________________________________

6. DeepSeek-R1-70B

• CPU: 32 核以上(服务器级 CPU)

• 内存: 128GB+

• 硬盘: 70GB+

• 显卡: 多卡并行(如 2x A100 80GB 或 4x RTX 4090)

• 场景:

• 科研机构/大型企业(金融预测、大规模数据分析)

• 高复杂度生成任务(创意写作、算法设计)

________________________________________

7. DeepSeek-R1-671B

• CPU: 64 核以上(服务器集群)

• 内存: 512GB+

• 硬盘: 300GB+

• 显卡: 多节点分布式训练(如 8x A100/H100)

• 场景:

• 国家级/超大规模 AI 研究(如气候建模、基因组分析)

• 通用人工智能(AGI)探索

1.1.3安装模型

本地运行cmd,输入ollama run deepseek-r1:1.5b

1.2 Linux平台安装

1.2.1运行一键安装脚本

curl -sSfL https://ollama.com/install.sh | sh

该脚本速度很慢,用手动方式安装

1.2.2手动安装

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

配置服务

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)

vi /etc/systemd/system/ollama.service

写入以下内容

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*"

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=$PATH"

[Install]

WantedBy=default.target

重启ollama

systemctl daemon-reload

systemctl restart ollama

1.3容器平台部署ollama

1.3.1 创建docker-compose.yml

vi docker-compose.yml

version: '3'

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- "11434:11434"

volumes:

- ./data:/data

进入容器

docker exec -it ollama /bin/bash

安装模型

ollama run deepseek-r1:1.5b

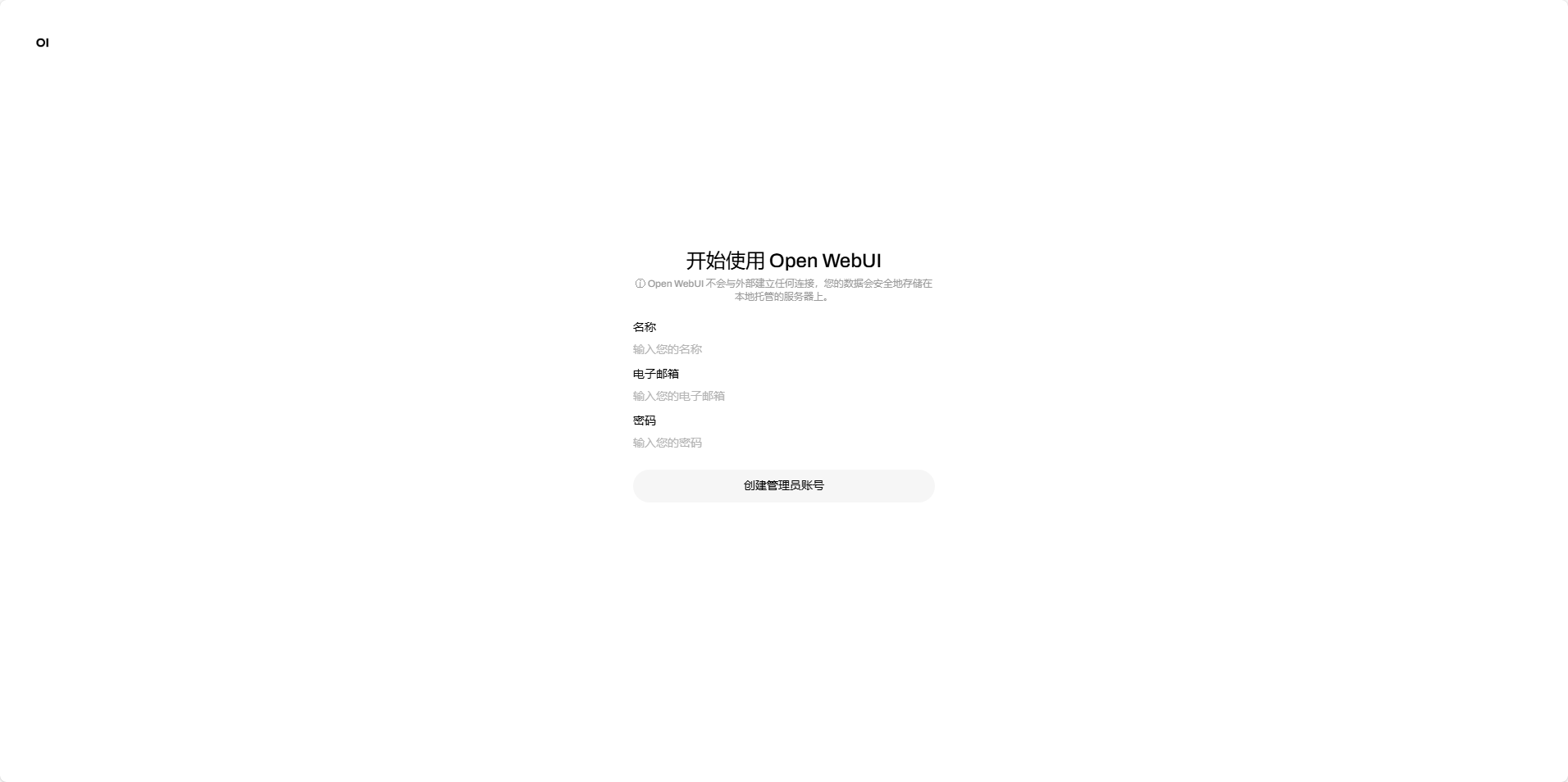

2 安装openwebui(web端)

2.1 Windows平台安装

2.1.1安装python3.11

不要用python3.11以上的版本,否则不兼容

到python官网下载python3.11

2.1.2安装open-webui

Pip换源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

安装

pip install open-webui

运行open-webui

open-webui serve

浏览器访问127.0.0.1:8080

2.2 容器部署openwebui

docker run -d -p 8080:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

3 安装Chabox(客户端)

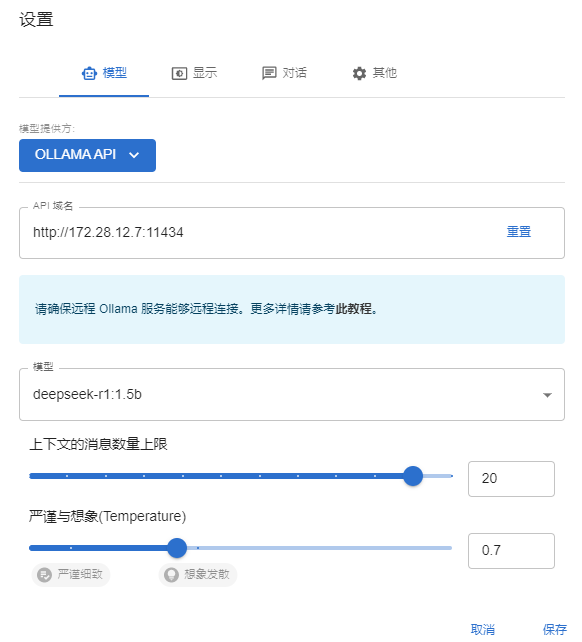

3.1设置api连接

3.2开放ollama允许远程访问

默认情况下ollama只允许本地访问连接

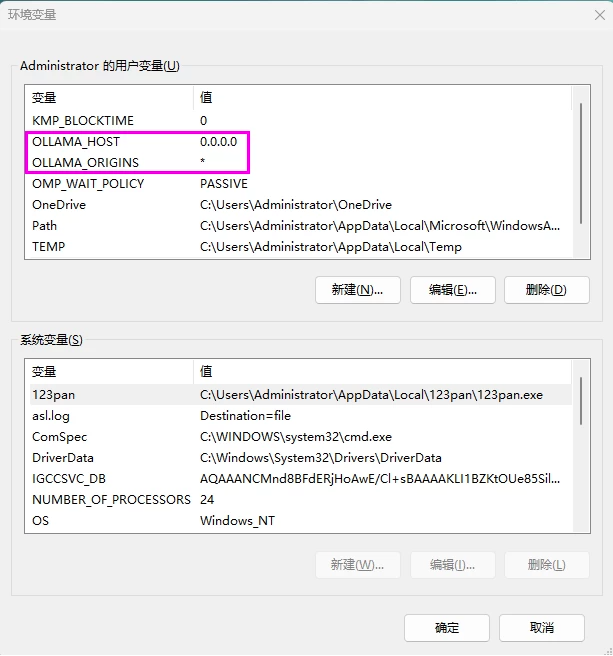

Windows平台

配置系统环境变量

4 linux安装显卡驱动

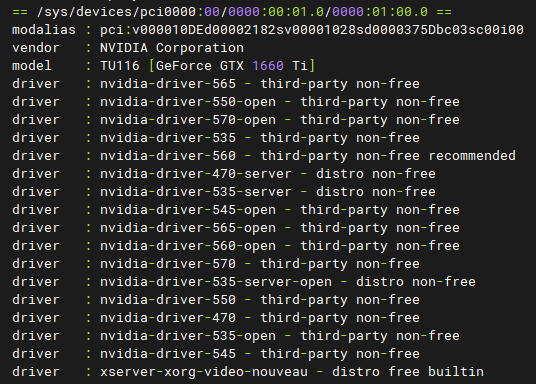

查看显卡型号 lspci | grep -i vga

更新系统

apt update

apt upgrade

重启

Reboot

禁用 Nouveau 显卡驱动

sudo nano /etc/modprobe.d/blacklist-nouveau.conf

写入以下内容

blacklist nouveau

options nouveau modeset=0

更新 initramfs

sudo update-initramfs -u

重启

Reboot

验证 Nouveau 是否已禁用

lsmod | grep nouveau

没有输出说明已经禁用

添加官方显卡驱动 PPA(可选)

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt update

查看推荐的驱动版本

ubuntu-drivers devices

Recommended是推荐

安装驱动

sudo apt install nvidia-driver-560

安装推荐的驱动

sudo ubuntu-drivers autoinstall

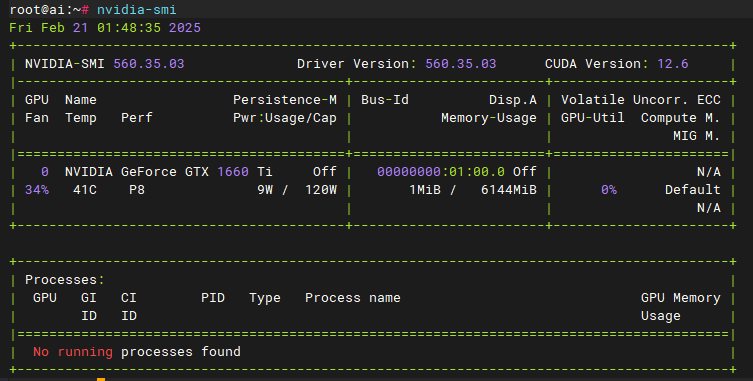

验证安装

nvidia-smi

移除显卡驱动

sudo apt-get remove --purge '^nvidia-.*'

sudo apt autoremove

如果出现安装显卡驱动自动关机的情况,按如下解决

禁用ACPI电源管理

编辑GRUB配置文件

sudo nano /etc/default/grub

修改为

GRUB_CMDLINE_LINUX_DEFAULT="quiet splash acpi=off"

更新GRUB

sudo update-grub

重启

Reboot

如果出现显卡驱动未加载成功,再将acpi重新开启

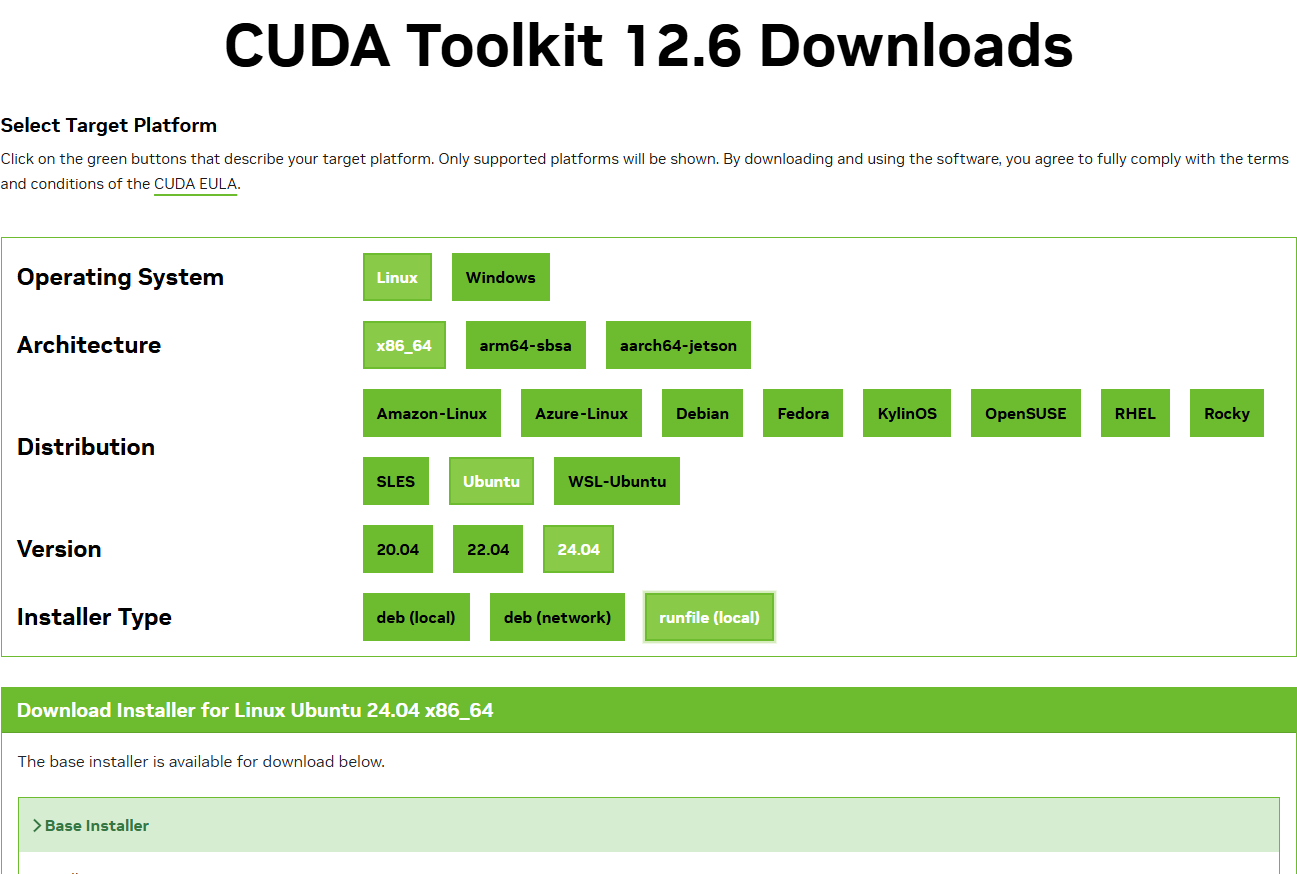

5 安装cuda

5.1 windows安装CUDA toolkit

如果出现运行大模型gpu利用率为0时,尝试安装cuda,再重装ollama

CUDA Toolkit Archive | NVIDIA Developer

5.2 linux安装CUDA toolkit

CUDA Toolkit Archive | NVIDIA Developer

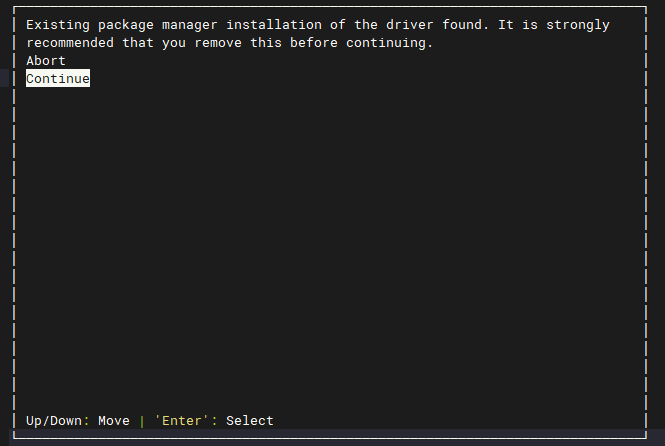

选择continue

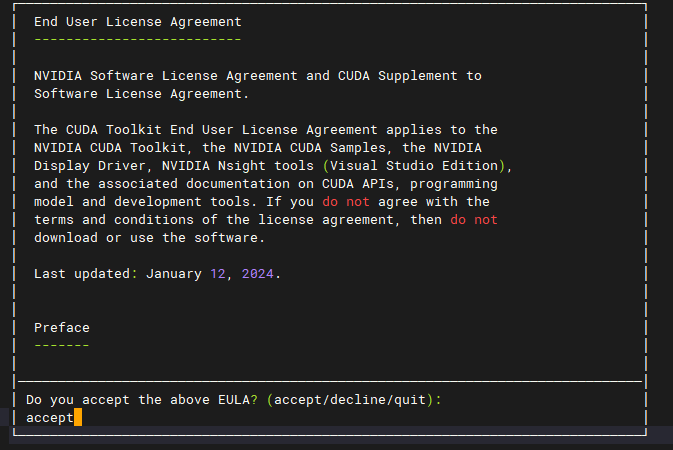

输入accept

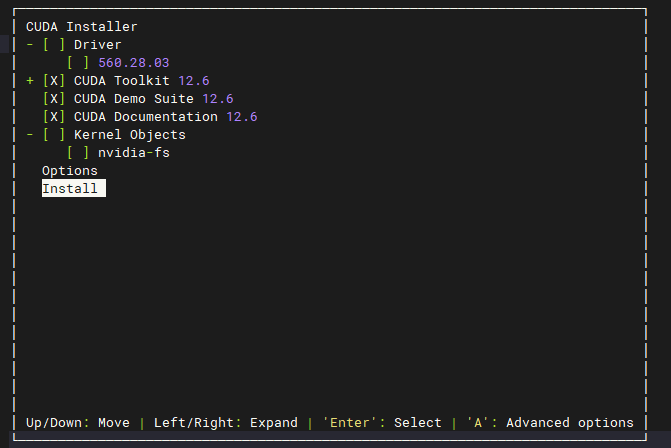

取消勾选driver

配置环境

nano ~/.bashrc

写入

export PATH=$PATH:/usr/local/cuda-12.6/bin

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-12.6/lib64

重载配置

source ~/.bashrc

检查是否安装成功

nvcc –V

License:

CC BY 4.0